CUỘC ĐUA AI VẪN CHƯA DỪNG LẠI, KHÔNG CHỈ DỪNG Ở PHẦN MỀM CÁC ÔNG LỚN CÒN THAM GIA VÀO VIỆC SẢN XUẤT CHIP AI

Công nghệ AI đang ngày càng được người dùng tiếp nhận trong đầu năm 2024, điều này không khó để nhận ra khi mà các công cụ phần mềm như ChatGPT của OpenAI hoặc các sản phẩm phần cứng như AI-pin của Humane, hay trong các công cụ liên quan đến chỉnh sửa hình ảnh. Tuy nhiên, đây mới chỉ là phần nổi của tảng băng khi nói đến công nghệ phát triển AI.

Một cuộc đua khốc liệt đang được hình thành trên thị trường giữa các ông lớn. Phần lớn các phần mềm hay phần cứng AI hoạt động một cách mượt mà thì đều dựa vào công nghệ của CPU. Một số sản phẩm hay dịch vụ AI còn tận dụng khả năng xử lý AI trên thiết bị (on-device AI) còn các sản phẩm khác thì chuyển yêu cầu sang máy chủ đám mây (Cloud AI). Dù có theo cách nào đi chăng nữa thì các bộ xử lý AI vẫn là sống lưng của AI, và đó là lý do tại sao các công ty công nghệ lớn đều đang tham gia vào một cuộc đua ngầm để tạo ra một bộ xử lý AI tốt nhất cho AI PC cũng như máy chủ đám mây.

Tầm quan trọng của CPU đối với hiệu năng của AI ?

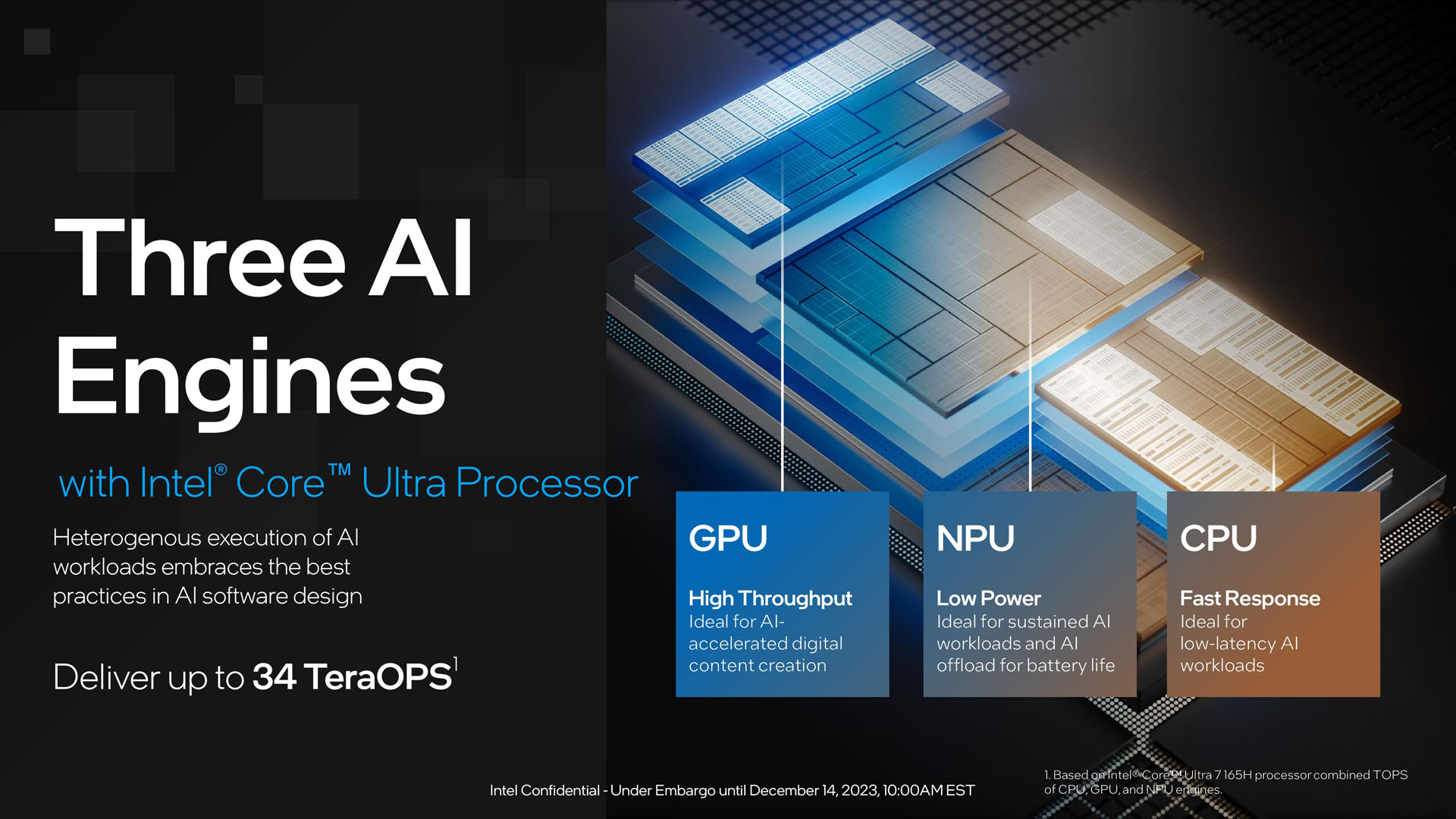

Trên các nền tảng di động thì AI đã được áp dụng từ lâu, còn trên Laptop cũng đang bắt đầu được trang bị các bộ xử lý thần kinh NPU, được thiết kế để chuyên quản lý các tác vụ liên quan đến AI. So với CPU hoặc GPU truyền thống, NPU có khả năng xử lý chức năng và phân tích thông tin cùng lúc tốt hơn nhiều. Vì vậy, trong khi GPU vẫn có thể xử lý một truy vấn đòi hỏi Deep Learning hoặc machine learning thì NPU lại giúp tăng tốc quá trình này. Sử dụng NPU so với các loại bộ xử lý khác không chỉ cho phép tính toán AI nhanh hơn, mà còn hỗ trợ cho các quy trình làm việc đòi hỏi cao hơn. Đó là lý do cho Apple cung cấp SoC với NPU trên cả iPhone và các thiết bị di động khác của họ trong nhiều năm qua. NPU gần đây cũng đã trở thành một phần quan trọng của phần cứng PC khi 2 ông lớn Intel và AMD cũng đều tích hợp sẵn NPU vào Chip của họ.

(CPU Intel Core Ultra với NPU tích hợp)

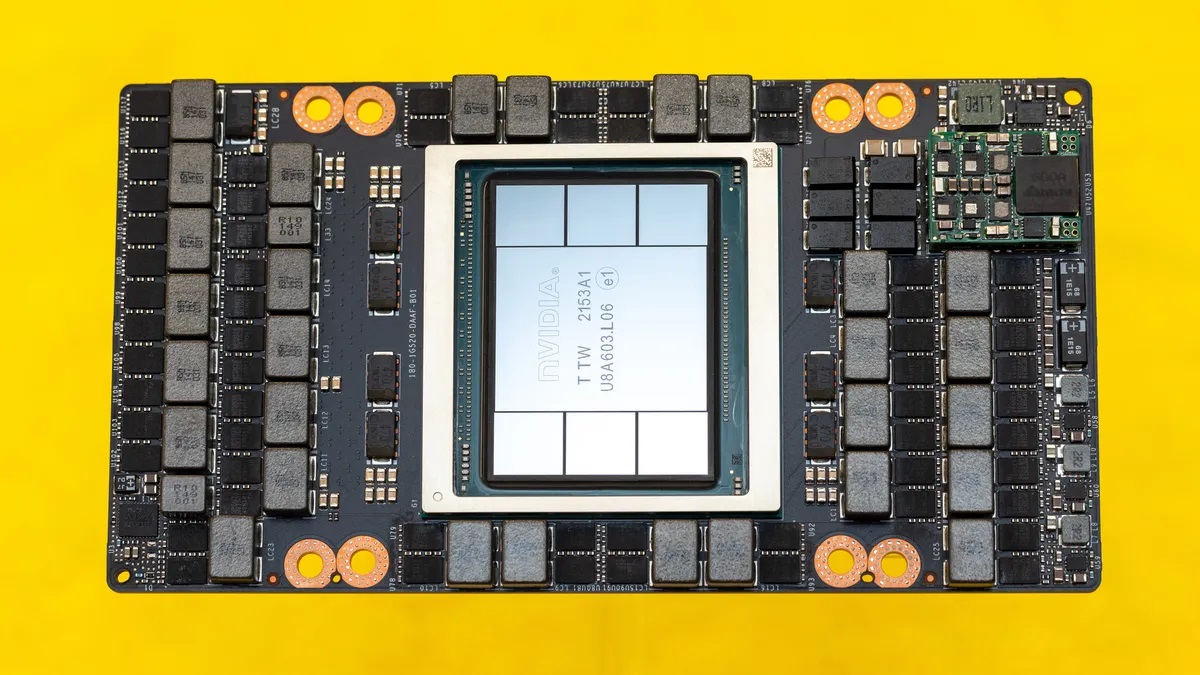

NPU chỉ có thể giúp chạy các tính năng AI nội bộ trong khi hầu hết các công cụ và tính năng phần mềm dựa trên AI ngày nay đều chạy bên ngoài thiết bị, chuyển các yêu cầu xử lý sang máy chủ đám mây ở một nơi khác. Ví dụ, khi bạn hỏi các chatbot AI như ChatGPT, Copilot hoặc Gemini một câu hỏi thì nó sẽ gửi câu hỏi đó đến máy chủ và xử lý các yêu cầu được đưa ra. Nhưng điều quan trọng cần nhớ là các máy chủ cũng cần bộ xử lý AI. Và trên thực tế, các bộ xử lý AI tiên tiến được sử dụng trong các máy chủ ở trung tâm dữ liệu đang có nhu cầu cao hơn nhiều so với các loại chip dành cho người tiêu dùng. Hiện tại, NVIDIA vẫn đang là một trong những công ty dẫn đầu về ngành sản xuất bộ vi xử lý AI và GPU H100 chuyên dùng cho các tác vụ AI và Deep Learning của họ đang rất khó tìm, với giá trị khoảng hơn 40.000 USD mỗi chiếc trên thị trường đồ cũ.

(GPU Nvidia H100)

Nvidia đang được các công ty công nghệ để ý nhiều nhất, nhất cử nhất động của NVIDIA với các GPU tiên tiến của họ, bao gồm cả H100 nói trên và H200 mới được công bố. Những con Chip này rất quan trọng để chạy các mô hình ngôn ngữ lớn LLM, hỗ trợ nhiều tính năng AI tạo sinh, với những thứ hiện hữu rõ ràng là Chatbot nhưng cũng có các trình tạo ảnh, trình tạo video...

Các tính năng của Google, Microsoft, Open AI và một số phần mềm khác đều cần đến chip AI tiên tiến để cung cấp sức mạnh cho dịch vụ của họ. Có thể nói là các công ty này đang cạnh tranh với nhau để thiết kế và mua lại những con chip sẽ đưa các ứng dụng AI của họ vào cuộc sống.

Không một ông lớn nào là không muốn có phần trong việc tạo chip AI, đó là lý do tại sao khi nhắc đến bất kỳ công ty công nghệ lớn nào cũng đều nghe đến việc họ sản xuất, thiết kế hoặc chế tạo chip AI dưới hình thức này hay bất kì một hình thức nào khác.

- Tuần trước, Google đã công bố một loại bộ vi xử lý mới có tên là Google Aixon. Đây là một loại chip Arm tùy chỉnh được thiết kế riêng cho các trung tâm dữ liệu hỗ trợ của Google Cloud

- Về phía của Microsoft thì có Azure Maia và Azure Cobalt, cả 2 bộ xử lý AI này sẽ được ra mắt trong năm nay nhằm tránh phụ thuộc vào các sản phẩm của Nvidia.

- Meta cũng đã thâm nhập vào lĩnh vực sản xuất chip với cái tên của riêng mình - MTIA (Meta Training and Inference Accelerator) được ra mắt vào năm ngoài, đông thời hộ cũng đã xem xét đến thế hệ tiếp theo chỉ mới tuần trước.

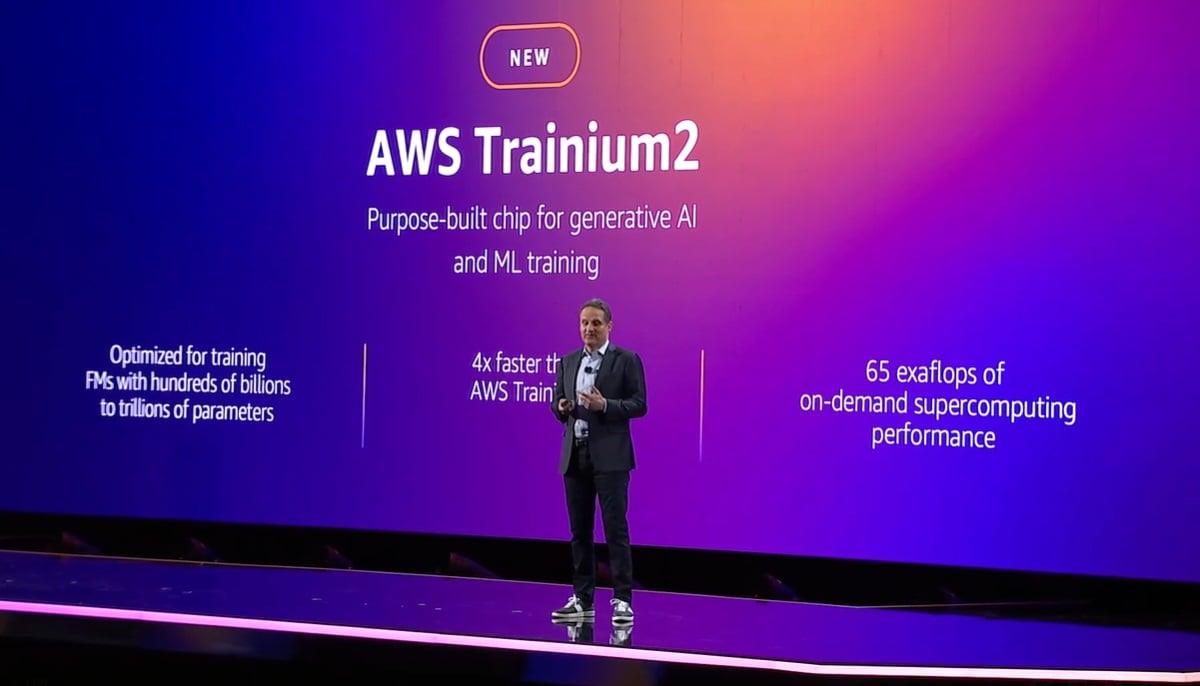

- Amazon Web Services thì có bộ xử lý Trainium 2 tùy chỉnh mới cho các tác vụ dựa trên AI, đồng thời cũng sử dụng chip NVIDIA cho các trung tâm dữ liệu của mình.

- CEO của OpenAI - Sam Altman được cho là cũng đang nhắm tới việc sản xuất các bộ xử lý AI tùy chỉnh.

(Amazon giới thiệu chip Trainium2)

Hiện tại, GPU H100 của Nvidia đang chiếm cho mình một vị trí quan trọng khi mà các công ty đều đang cần nó để xử lý AI dựa trên đám mây. Amazon Web Services, Microsoft Azure và Google Cloud là 3 nhà cung cấp dịch vụ xử lý đám mây lớn nhất hiện nay, và tất cả đều phải phụ thuộc vào Nvidia để cung cấp AI, khả năng tính toán deep learning và machine learning cho khách hàng của họ CEO Meta - Mark Zuckerburg cho biết đang lên kế hoạch để mua 340.000 GPU Nvidia H100 vào cuối năm nay.

Các công ty lớn cũng đã nhấn mạnh việc quan hệ lâu dài với công ty sản xuất chip này, nhưng chỉ với điều này là không đủ với họ. chính vì thế nên các ông lớn: Amazon, Microsoft, Google và Meta đều đang chuẩn bị các giải pháp chip thay thế của riêng mình, và công ty nào cạnh tranh được với Nvidia thì có thể sẽ là người chiến thắng cuối cùng trong cuộc đua AI.

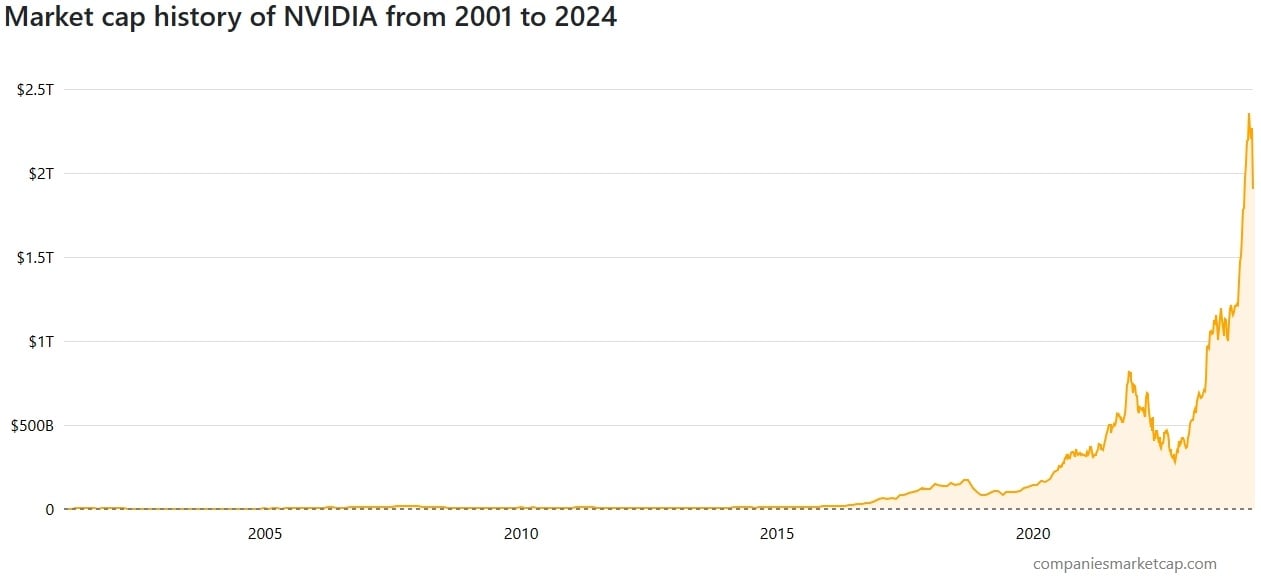

Nvidia cũng đã thu về cho mình một khoản tiền khổng lồ từ việc sản xuất và phân phối CPU AI. Cũng không khó để nhìn ra việc các công ty đang đối đầu với nhau để phát triển các tính năng phần mềm và LLM tốt hơn. Tuy nhiên, nếu nhìn sâu hơn thì Microsoft, Google, Amazon và Meta cũng cần phải đánh bại nhau về phần cứng để có thể giành chiến thắng về phần mềm.

Nvidia hiện đang là ông vua cùa ngành AI và sự thành công của các công ty khác đều phụ thuộc vào việc tiếp cận với các GPU của Nvidia. Thành công của Nvidia cũng đã cho thấy rõ động cơ tài chính ở đây, mới vài ngày trước giá cổ phiếu của Nvidia đã tăng lên 218,5 % trong năm qua và nó đã trở thành công ty chiếm giữ hàng nghìn tỉ USD nhờ sự thống trị trong lĩnh vực sản xuất công nghệ AI.

Bài viết liên quan

29.03.2025, 7:42 pm 205

Streamer Cần Những Gì Để Lên Sóng Chuyên Nghiệp

Bạn có từng mơ ước trở thành một streamer chuyên nghiệp, tự tin giao lưu với hàng trăm, thậm chí hàng nghìn người xem mỗi ngày? Nghe có vẻ hấp dẫn đúng không? Nhưng để đạt được điều đó, bạn cần chuẩn bị từ những điều cơ bản nhất. Là một người bạn đồng hành, hôm nay XUÊ PC sẽ hướng dẫn bạn từ A đến Z những thứ cần thiết để bắt đầu hành trình trở thành một streamer chuyên nghiệp. Chúng ta sẽ nói về thiết bị, kỹ năng và cả những yếu tố nhỏ nhưng vô cùng quan trọng. Sẵn sàng chưa? Bắt đầu thôi.

29.03.2025, 7:14 pm 170

Công Nghệ Ray Tracing Của Nvidia 💡 Đột Phá Đồ Họa Đỉnh Cao

Trong thế giới công nghệ đồ họa ngày nay, Ray Tracing được xem như một bước đột phá, làm thay đổi hoàn toàn cách ánh sáng và bóng đổ được tái tạo trong không gian số. Công nghệ này không chỉ mang đến những hình ảnh chân thực vượt bậc mà còn mở ra kỷ nguyên mới cho game thủ và các nhà sáng tạo nội dung. Là người tiên phong trong lĩnh vực này, Nvidia đã đưa Ray Tracing trở thành tiêu chuẩn trong ngành, với sự hỗ trợ từ dòng card đồ họa RTX.

29.03.2025, 6:19 pm 188

Công Nghệ Card Màn Hình Nvidia: Tương Lai Của Đồ Họa ✨

Card màn hình Nvidia từ lâu đã trở thành sự lựa chọn hàng đầu của game thủ, nhà thiết kế đồ họa và các nhà nghiên cứu khoa học nhờ vào hiệu suất vượt trội và công nghệ tiên tiến.

29.03.2025, 3:24 pm 129

Mainboard Là Gì? Linh Kiện Quan Trọng Nhất Của Máy Tính

Mainboard hay còn được gọi là bo mạch chủ chính là “trái tim” của mọi hệ thống máy tính, đóng vai trò kết nối và điều khiển tất cả các thành phần trong máy tính

26.03.2025, 6:41 pm 127

Mainboard MSI: Công Nghệ Tiên Tiến, Độ Ổn Định Cao

Bạn đang tìm kiếm một chiếc mainboard vừa mạnh mẽ, đáng tin cậy lại được tích hợp công nghệ hiện đại? Mainboard MSI chính là sự lựa chọn hoàn hảo dành cho bạn. Với danh tiếng lâu năm trong ngành công nghiệp phần cứng, MSI không chỉ nổi bật nhờ công nghệ tiên tiến mà còn đảm bảo độ ổn định cao cho mọi nhu cầu sử dụng, từ chơi game, làm việc đến sáng tạo nội dung.

17.04.2024, 11:39 am 142

CÓ THỰC SỰ CẦN THIẾT NÂNG CẤP RAM LÊN 16GB HAY KHÔNG ??? LỢI ÍCH CỦA VIỆC NÂNG CẤP

15.04.2024, 12:08 pm 116

BIOSTAR CHO RA MẮT GPU INTEL A750PHÙ HỢP VỚI NGÂN SÁCH CỦA NGƯỜI DÙNG

11.04.2024, 9:34 am 132

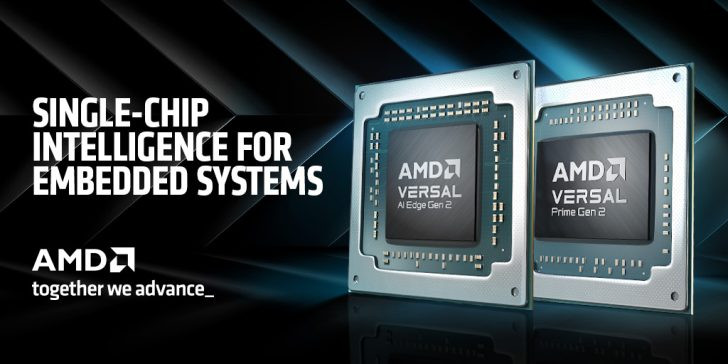

AMD phát hành SoC thích ứng Versal Gen 2, cạnh tranh mạnh mẽ trên thị trường AI nhúng

08.04.2024, 10:48 am 139

Apple đang lên kế hoạch phát triển Robot có thể thực các công việc gia đình

02.04.2024, 10:02 am 131

.png)